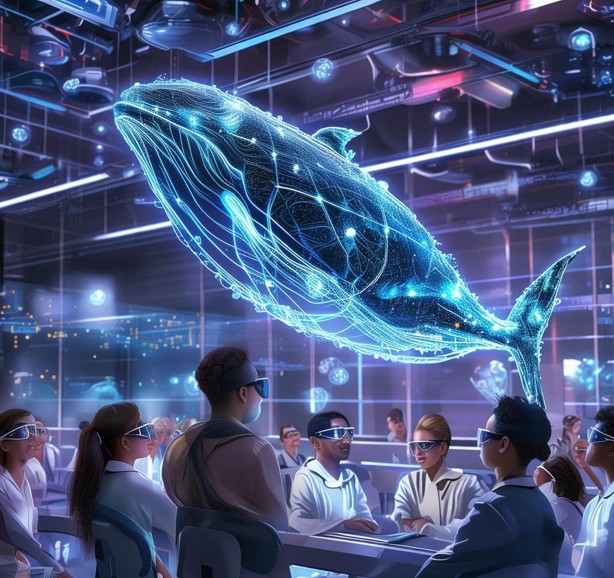

在人工智能领域,大语言模型的发展日新月异,而其背后的技术——解码与部署,更是关键中的关键。今天,就让我们一起走进数据whale的组队学习之旅,深入探讨大语言模型在解码与部署方面的那些事儿。

一、解码的艺术:从提问到答案

当我们向机器提出一个问题时,它首先需要理解我们的意图。这一步,主要是通过解码器来完成的。解码器的工作原理多种多样,其中最为常见的是transformer的自回归解码器。想象一下,解码器就像是一个聪明的孩子,能够根据我们的问题,一步步地推理出答案。

经典解码算法如贪心算法,每一步都选择当前最优解。但这种方法往往容易陷入局部最优,无法找到真正的答案。为了解决这个问题,人们引入了束搜索、随机采样等技术,通过多次尝试,逐渐逼近最优解。

此外,温度词元、top-k、top-p等策略的引入,更是为解码过程增添了更多的趣味性和灵活性。这些策略就像是我们给解码器增加了一些“智慧”,让它能够在更多元化的路径中寻找答案。

二、部署的挑战:从理论到实践

解码完成之后,就需要将模型部署到生产环境中。然而,这一步并不像解码那么简单。模型需要被压缩,以减小其占用的空间,这就涉及到了量化、蒸馏、剪枝等技术。这些技术就像是我们给模型做了一次“减肥”,让它变得更加轻便和高效。

当然,压缩后的模型还需要进行优化,以确保其在实际应用中的性能。这就需要我们平衡运算量、访存量、计算强度等指标,就像是在进行一场优化的比赛。

三、最优化问题的魅力:无处不在的挑战

在模型解码与部署的过程中,我们总能遇到各种各样的最优化问题。无论是算法的选择、参数的调整,还是策略的组合,都需要我们不断地进行尝试和优化。但正是这些挑战,让我们的技术不断进步,让我们的生活更加美好。

数据whale的组队学习之旅让我们深刻体会到了这一点。他们通过不断的尝试和优化,成功地将大语言模型的能力发挥到了极致。这也让我们看到了人工智能技术的无限可能。

总之,《Datawhale组队学习-大语言模型-day06》这篇文章为我们揭开了大语言模型解码与部署的神秘面纱。通过深入了解这些技术原理和应用策略,我们可以更好地利用大语言模型来解决实际问题,推动人工智能技术的不断发展。

声明:

1、本博客不从事任何主机及服务器租赁业务,不参与任何交易,也绝非中介。博客内容仅记录博主个人感兴趣的服务器测评结果及一些服务器相关的优惠活动,信息均摘自网络或来自服务商主动提供;所以对本博客提及的内容不作直接、间接、法定、约定的保证,博客内容也不具备任何参考价值及引导作用,访问者需自行甄别。

2、访问本博客请务必遵守有关互联网的相关法律、规定与规则;不能利用本博客所提及的内容从事任何违法、违规操作;否则造成的一切后果由访问者自行承担。

3、未成年人及不能独立承担法律责任的个人及群体请勿访问本博客。

4、一旦您访问本博客,即表示您已经知晓并接受了以上声明通告。

本站资源仅供个人学习交流,请于下载后24小时内删除,不允许用于商业用途,否则法律问题自行承担。

Copyright 2005-2024 yuanmayuan.com 【源码园】 版权所有 备案信息

声明: 本站非腾讯QQ官方网站 所有软件和文章来自互联网 如有异议 请与本站联系 本站为非赢利性网站 不接受任何赞助和广告